专注AIGC领域的研究探索,关注OpenAI、Claude、讯飞星火等大语言模型(LLM)的发展和应用落地,关注LLM的基准评测和市场研究,并为企业提供AI业务的相关服务。

OpenAI发布新功能助力企业构建专属ChatGPT

今日早间,OpenAI通过其官方渠道公布,已正式为GPT-3.5 Turbo版本推出了微调功能,并且同步更新了相应API。这一更新意味着企业和开发者现在能够依靠自身的数据资源,为特定的业务场景构建定制化的ChatGPT。值得关注的是,GPT-4版本的这项功能也即将在今年秋季与大家见面。

根据OpenAI提供的初步测试数据显示,当针对某些具体任务进行微调时,GPT-3.5 Turbo的性能甚至有可能匹配或超越GPT-4的初始版本。更多相关的技术细节和说明可以在OpenAI的官方文档中查阅:OpenAI官方文档。

大语言模型微调在法律领域的实际应用

近年来,大语言模型的微调功能逐渐成为企业实际应用的核心技术之一。以法律行业为例,包括Spellbook、律商联讯、Litera、Casetext等知名机构,都已经开始依赖这项技术。他们利用自身积累的大量法律数据,对GPT-4模型进行专业微调和预训练,从而打造出专为法律领域设计的ChatGPT。这种特定行业的模型微调,确保了输出内容的专业度、安全性和准确率。

自GPT-3.5 Turbo发布以来,开发人员和企业希望能够开发自定义大模型,为用户创造独特、差异化的产品体验。现在,OpenAI终于开放了此功能,使得人人都能打造独一无二的专属ChatGPT。

什么是微调

微调用例

根据OpenAI的官方微调说明文档,列出了以下常见用例:

-

设置风格、基调、格式等; -

提高输出的可靠性; -

纠正未能遵循复杂提示的问题; -

以特定方式处理多个边缘内容; -

改进可操纵性; -

执行难以在提示中阐明的新技能或任务。

例如,改进可操纵性,微调功能允许企业使模型更好地遵循指令,使输出简洁或始终以特定语言进行响应。例如,开发人员可以使用微调来确保模型,在提示使用德语时始终以德语进行响应。

除了提高性能之外,微调使企业能够缩短提示时间同时保证性能。GPT-3.5-Turbo微调还可以处理4k tokens,是OpenAI之前微调模型的两倍。

早期测试人员通过对模型本身的指令进行微调,将提示大小减少了高达 90%,从而加快了每个API调用的速度并降低了成本。

如何进行微调

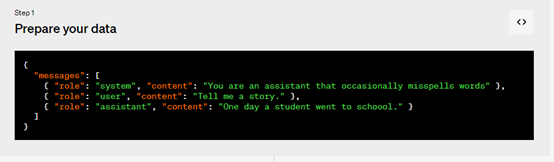

1,准备数据,创建一组多样化的演示对话,类似于要求模型在实际输出中的对话。数据集中的每个示例都应该与OpenAI的聊天完成 API 格式相同的对话,特别是消息列表,其中每条消息都有角色、内容和可选名称。

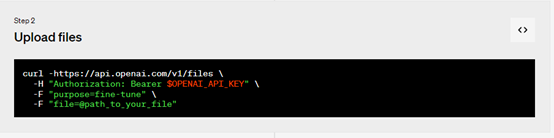

2,上传文件

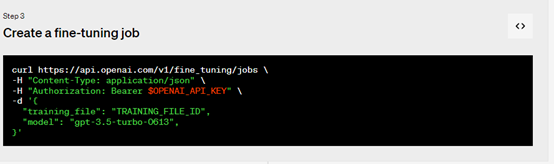

3,创建微调作业,使用 OpenAI SDK开始进行大规模数据训练、微调。训练模型可能需要几分钟或几小时,具体取决于模型和数据集大小。模型训练完成后,创建微调作业的用户将收到一封确认电子邮件。

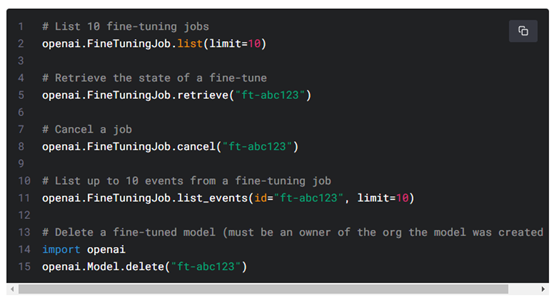

除了创建微调作业外,开发者还可以列出现有作业、检索作业状态或取消作业。

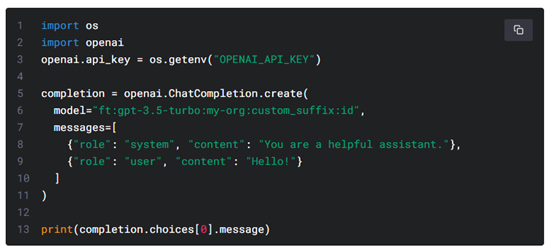

4,使用微调模型,微调作业完成后模型可以投入使用了。

在某些情况下,用户的微调模型可能需要几分钟才能准备好处理请求。如果对模型的请求超时或找不到模型名称,可能是因为模型仍在加载中,可在几分钟后重试。

微调定价

微调分为初始训练成本和使用成本两大部分。

训练:0.008 美元/1K tokens。

使用输入:0.012 美元/1K tokens。

使用输出:0.016 美元/1K tokens。

例如,一个GPT-3.5 Turbo包含 100,000 个okens的训练文件并训练3个epoch的微调作业的预期成本为2.40美元。

本文素材来源OpenAI官网,如有侵权请联系删除